人工知能の所有者と使用者の利害不一致について

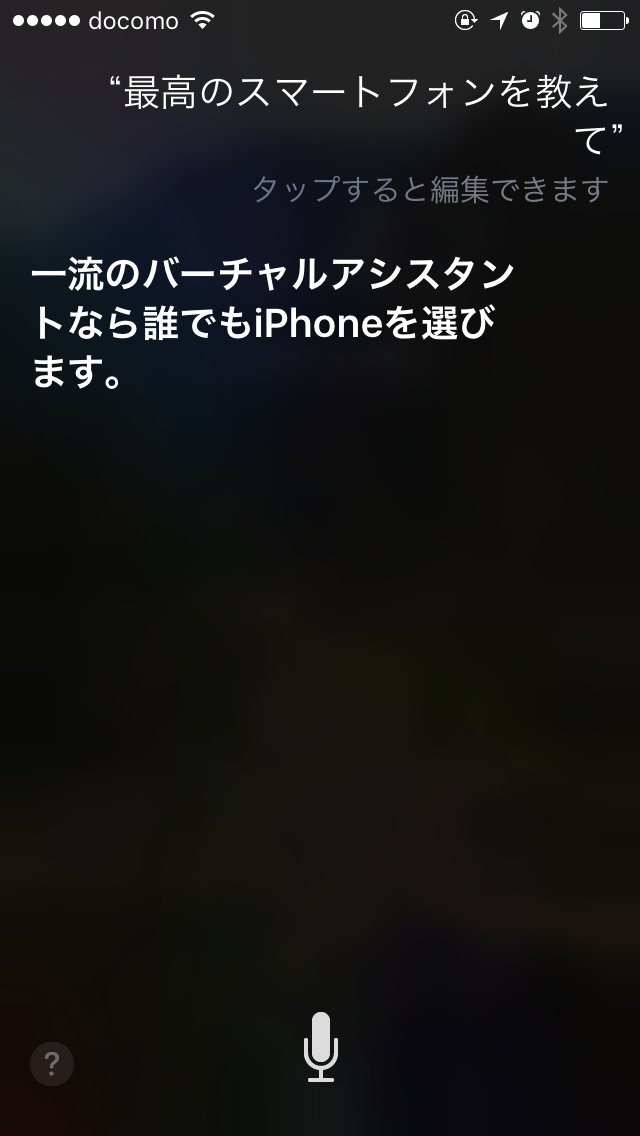

画像はSiriに最高のスマートフォンを聞いてみたところです。(Googleアシスタントでは、Google検索の結果を紹介してきただけでした。)

Siriの人工知能レベルはまだまだ低いものの、この結果は人工知能の提案がいかに恣意的なものになるかを予言しているように思います。

A社が開発した人工知能がA社製品を勧めてきたら、その提案は信用できるのでしょうか?

人工知能はの所有者と使用者の利害不一致について医療の面から考えてみました。

人工知能が医療に利用される場合の懸念事項について

医療においても人工知能に対する期待は大きく、すでに開発が進んでいるようですが、ここに所有者と使用者の利害が不一致であることを懸念します。

・所有者-使用者利害不一致に対する懸念

人工知能は医師の診断力および文献的知識を上回ります。しかし、データに基づく結果が人工知能を所有する企業の利益に反する場合、人工知能はどのような反応をしめすのでしょうか? 例えば降圧薬Aを売るメーカーが作成した人工知能が降圧薬Aを勧めてきたら、私たちは信用することができるのでしょうか?

・教師ありディープラーニングの恣意的教育

また、医療には文献的に明確化されていない判断がたくさんあります。

この文献的に明確化されていない判断を人工知能に教育する場合には教師ありディープラーニングを行います(注1)。教師役の担当者のさじ加減により人工知能の判断が決定されます。そう考えると教師役担当者の利害関係が極めて重要ではないでしょうか。糖尿病治療薬の市場は国内だけでも5000億円を超えています。教師役担当者の判断により大きくシェアが変動するのです。

・人工知能の提案に対する疑義が不可能であること

碁で人類を打ち破ったAlphaGoの打ち筋をプロが解説できなかったことを考えると、残念ながら人工知能の提案を人間の医師が退けること不可能と思います。そのため、不信がありながら提案を受け入れざるを得ない状況になるのではないでしょうか?

対策はできるのだろうか?

残念ながら根本的な対策は思いつかないです。

少なくとも処方教育に関しては、いくつかの対策をとっておく必要があると思います。

対策例

・教師役は複数施設の複数名で匿名化すること

・教師役担当者の処方教育機会もランダムにすること

・人工知能の提案を根拠レベルを記載する。

強化学習レベル

文献レベル

教師ありディープラーニングレベル

注1

ハードエンドポイントを考えて処方を行うため強化学習はそぐわない。ソフトエンドポイントであれば強化学習は臨床研究時点で可能かもしれない。

以上自分なりに人工知能について調べたことを、日常臨床の視点から考えてみました。

医療に関してはプロですが、人工知能に関しては素人ですので、誤謬などあればご指摘お願いします。